diff --git a/CONDUCT-es-419.md b/CONDUCT-es-419.md

new file mode 100644

index 0000000..37ef03e

--- /dev/null

+++ b/CONDUCT-es-419.md

@@ -0,0 +1,8 @@

+# Código de conducta

+

+Como proyecto entre 2i2c y MetaDocencia, el proyecto ScienceCore:climaterisk está sujeto a las políticas siguientes:

+

+- [Código de conducta de 2i2c](https://compass.2i2c.org/code-of-conduct)

+- [Pautas de Convivencia de MetaDocencia](https://www.metadocencia.org/pdc)

+

+Puede seguirse el procedimiento de notificación de cualquiera de las dos políticas.

diff --git a/CONTRIBUTING-es-419.md b/CONTRIBUTING-es-419.md

new file mode 100644

index 0000000..a627abf

--- /dev/null

+++ b/CONTRIBUTING-es-419.md

@@ -0,0 +1,13 @@

+# Contribuciones

+

+Este repositorio ha sido creado mediante una colaboración entre 2i2c y MetaDocencia. Para hacer un cambio en este repositorio, por favor genera un _pull request_.

+

+Si el cambio es menor(como un arreglo de formato o una corrección gramatical), se invita a quienes proporcionan mantenimiento a auto-mergear el cambio sin revisión (omitiendo las protecciones de la rama).

+

+Si el cambio no es trivial, solicita una revisión a otro miembro del equipo de ScienceCore:climaterisk.

+

+Una vez que el cambio haya sido aprobado, el PR podrá fusionarse. Si el PR proviene de un miembro del equipo de ScienceCore:climaterisk, normalmente se fusionará por sí mismo. Si el RP proviene de alguien externo al equipo ScienceCore:climaterisk, cualquier miembro de ese equipo puede hacer la fusión o merge.

+

+## Código de conducta

+

+Ten en cuenta que este tutorial ScienceCore: Determinación de riesgos con NASA Earthdata Cloud se publica con un [Código de conducta de contribuidores](CONDUCT.md). Al contribuir con este proyecto, te comprometes a cumplir sus términos.

diff --git a/book/es-419/01_Geospatial_Background/02_Working_with_Raster_Data.md b/book/es-419/01_Geospatial_Background/02_Working_with_Raster_Data.md

new file mode 100644

index 0000000..004f0be

--- /dev/null

+++ b/book/es-419/01_Geospatial_Background/02_Working_with_Raster_Data.md

@@ -0,0 +1,136 @@

+---

+jupytext:

+ text_representation:

+ extension: .md

+ format_name: markdown

+ format_version: "1.3"

+ jupytext_version: 1.16.2

+kernelspec:

+ display_name: Python 3 (ipykernel)

+ language: python

+ name: python3

+---

+

+# Cómo trabajar con datos ráster

+

+De la [descripción de Wikipedia sobre las _imágenes ráster_](https://es.wikipedia.org/wiki/Imagen_de_mapa_de_bits):

+

+> En [computación gráfica](https://es.wikipedia.org/wiki/Computaci%C3%B3n_gr%C3%A1fica) y [fotografía digital](https://es.wikipedia.org/wiki/Fotograf%C3%Ada_digital), un gráfico rásterizado representa una imagen bidimensional como una matriz rectangular o rejilla de [píxeles](https://es.wikipedia.org/wiki/P%C3%Adxel), que puede visualizarse mediante una [pantalla de computadora](https://en.wikipedia.org/wiki/Computer_display), [_paper_](https://en.wikipedia.org/wiki/Paper), o cualquier otro medio de visualización.

+

+El término _"dato ráster"_ o _"ráster"_ proviene de los gráficos por computadora. En esencia, un ráster se refiere a una secuencia de valores numéricos dispuestos en una tabla rectangular (similar a una [matriz](https://es.wikipedia.org/wiki/Matriz_\(matem%C3%A1tica\)) de [álgebra lineal](https://es.wikipedia.org/wiki/%C3%81lgebra_lineal)).

+

+Los conjuntos de datos ráster son útiles para representar cantidades continuas, como presión, elevación, temperatura, clasificación de la cobertura terrestre, etc., muestreadas en una [teselación](https://es.wikipedia.org/wiki/Teselado), es decir, una cuadrícula discreta que divide una región bidimensional de extensión finita. En el contexto de los [Sistemas de Información Geográfica (GIS, por las siglas en inglés de, _Geographic Information System_)](https://en.wikipedia.org/wiki/Geographic_information_system), la región espacial es la proyección plana de una porción de la superficie terrestre.

+

+Los rásters se aproximan a las distribuciones numéricas continuas almacenando valores individuales dentro de cada celda de la _cuadrícula_ o _píxel_ (un término derivado del _"elemento de imagen"_ en los gráficos por computadora). Los rásters pueden representar datos recopilados en varios tipos de celdas de cuadrícula no rectangulares (por ejemplo, hexágonos). Para nuestros fines, restringiremos nuestra atención en las cuadrículas en las que todos los píxeles son rectángulos que tienen el mismo ancho y alto.

+

+

+

+En esta imagen se muestra un ejemplo de datos ráster. Fuente: *National Ecological Observatory Network* (NEON)(en español, Red Nacional de Observatorios Ecológicos).

+

+

+---

+

+## Cómo comprender los valores de los ráster

+

+Una diferencia sutil e importante entre una matriz numérica conocida del álgebra lineal y un ráster en el contexto de los SIG es que los conjuntos de datos reales a menudo están _incompletos_. Es decir, un ráster puede carecer de entradas o puede incluir valores de píxeles que se corrompieron durante el proceso de medición. Por eso, la mayoría de los datos ráster incluyen un esquema para representar los valores "Sin datos" de los píxeles en los que no es posible hacer una observación significativa. El esquema puede utilizar "No es un número" (["NaN" , por las siglas en inglés de _Not-a-Number_](https://es.wikipedia.org/wiki/NaN)) para los datos de punto flotante o un [_valor testigo_](https://en.wikipedia.org/wiki/Sentinel_value) para los datos enteros (por ejemplo, utilizando -1 para señalar los datos que faltan cuando los datos enteros significativos son estrictamente positivos).

+

+Otra propiedad importante de los datos ráster es que los valores de los píxeles se almacenan utilizando un _tipo de datos_ apropiado para el contexto. Por ejemplo, las funciones continuas, como la altitud o la temperatura, suelen almacenarse como datos ráster utilizando números de punto flotante. Por el contrario, las propiedades categóricas (como los tipos de cobertura del suelo) pueden almacenarse utilizando números enteros sin signo. Los conjuntos de datos ráster suelen ser grandes, así que elegir el tipo de datos siguiendo un criterio puede reducir significativamente el tamaño del archivo sin comprometer la calidad de la información. Veremos esto con ejemplos más adelante.

+

+---

+

+## Comprensión del Píxel vs. Coordenadas continuas

+

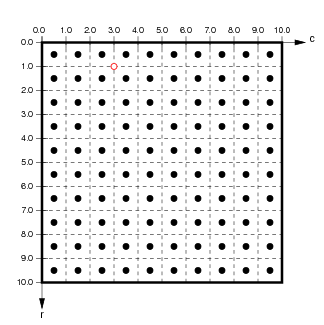

+Cada píxel de un ráster está indexado por su posición en la _fila y columna_ con respecto a la esquina superior izquierda de la _imagen_ o de las _coodenadas del píxel_. Estos valores representan el desplazamiento desde la esquina superior izquierda de la matriz, expresado convencionalmente utilizando una [_indexación desde cero_](https://en.wikipedia.org/wiki/Zero-based_numbering) (en inglés, _zero based numbering_). Por ejemplo, si se utiliza la indexación desde cero en la cuadrícula de píxeles $10\tveces10$ que se muestra a continuación, el píxel de la esquina superior izquierda tendrá el índice (0,0), el píxel de la esquina superior derecha tendrá el índice (0,9), el píxel de la esquina inferior izquierda tendrá el índice (9,0), y el píxel de la esquina inferior derecha tendrá el índice (9,9).

+

+

+

+(de `http://ioam.github.io/topographica`)

+

+La indexación desde cero no se observa universalmente (por ejemplo, MATLAB utiliza la indexación basada en matrices y arreglos), así que debemos ser conscientes de cuál convención se utiliza en cualquier herramienta utilizada. Sin importar si vamos a contar filas/columnas desde uno o desde cero, cuando se utilizan coordenadas de píxel/imagen/matriz, convencionalmente, el índice de la fila aumenta desde la fila superior y aumenta al desplazarse hacia abajo.

+

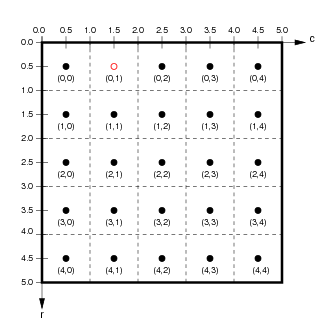

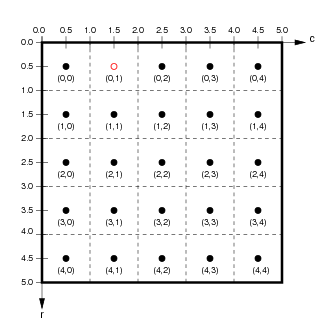

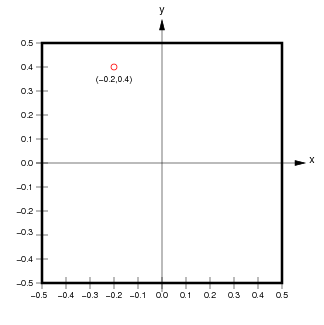

+Otra sutil distinción entre matrices y rásters es que los datos ráster suelen estar _georreferenciados_, esto significa que cada celda está asociada a un rectángulo geográfico concreto de la superficie terrestre con cierta área positiva. Esto a su vez significa que cada valor del píxel está asociado no solo con sus coordenadas de píxel/imagen, sino también con las coordenadas continuas de cada punto espacial dentro de ese rectángulo físico. Es decir, hay un _continuo_ de coordenadas espaciales asociadas a cada píxel en contraposición a un único par de coordenadas del píxel. Por ejemplo, en la cuadrícula de píxeles $5\times5$ que se muestra a continuación en el gráfico de la izquierda, el punto rojo asociado a las coordenadas del píxel $(0,1)$ se encuentra en el centro de ese píxel. Al mismo tiempo, el gráfico de la derecha muestra un punto rojo con coordenadas continuas $(-0,2,0,4)$.

+

+

+

+

+(from `http://ioam.github.io/topographica`)

+

+Hay dos distinciones importantes que se deben observar:

+

+- Las coordenadas de imagen se expresan normalmente en orden inverso a las coordenadas continuas. Es decir, para las coordenadas de imagen $(f,c)$, la posición vertical, la fila $f$, es la primera ordenada, y la posición horizontal, la columna $c$, es la segunda ordenada. Por el contrario, cuando se expresa una posición en coordenadas continuas $(x,y)$, convencionalmente, la posición horizontal $x$ es la primera ordenada y la posición vertical $y$ es la segunda ordenada.

+- La orientación del eje vertical se invierte entre coordenadas de píxel y coordenadas continuas (aunque la orientación del eje horizontal es la misma). Es decir, el índice de fila $f$ aumenta _hacia abajo_ desde la esquina superior izquierda en coordenadas del píxel, mientras que la coordenada vertical continua $y$ aumenta hacia arriba desde la esquina inferior izquierda.

+

+Las convenciones contradictorias con la indexación basada en cero y el orden de las coordenadas son fuente de muchos problemas en programación. Por ejemplo, en la práctica, algunas herramientas SIG exigen que las coordenadas se proporcionen como `(longitud, latitud)` y otras como `(latitud, longitud)`. Con suerte, los usuarios de SIG pueden confiar en que las herramientas de _software_ manejen estas inconsistencias de forma transparente (consulta, por ejemplo, [esta discusión en la documentación de Holoviz](https://holoviews.org/user_guide/Continuous_Coordinates.html)). Cuando los resultados calculados no tienen sentido, lo importante es preguntar siempre:

+

+- qué convenciones se utilizan para representar los datos ráster que se recuperaron de una fuente determinada, y

+- qué convenciones requiere cualquier herramienta SIG se utiliza para manipular datos ráster.

+

+---

+

+## Conservación de los metadatos

+

+Los datos ráster usualmente van acompañados de una variedad de _metadatos_. Estos pueden incluir:

+

+- el _Sistema de Referencia de Coordenadas (SRC)(en inglés, _Coordinate Reference System_, CRS)_: las posibles representaciones incluyen el [_registro EPSG_](https://en.wikipedia.org/wiki/EPSG_Geodetic_Parameter_Dataset), [_WKT_](https://en.wikipedia.org/wiki/Well-known_text_representation_of_coordinate_reference_systems), etc.

+- el valor _NoData_: el/los valor(es) testigo/s que señalan datos ausentes/corruptos (por ejemplo, `-1` para datos enteros o `255` para datos enteros de 8 bits sin signo, etc.).

+- la _resolución espacial_: el área (en unidades adecuadas) de cada píxel.

+- los _límites_: es la extensión del rectángulo espacial georreferenciado por estos datos ráster.

+- la _fecha y hora de adquisición_: la fecha de adquisición de los datos, que a menudo se especifica mediante el [_Tiempo Universal Coordinada_](https://es.wikipedia.org/wiki/Tiempo_universal_coordinado) (UTC, por sus siglas en iglés de _Coordinated Universal Time_).

+

+Los distintos formatos de archivo utilizan diferentes estrategias para adjuntar metadatos a un determinado conjunto de datos ráster. Por ejemplo, los productos de datos NASA OPERA generalmente tienen nombres de archivo como:

+

+```

+OPERA_L3_DIST-ALERT-HLS_T10TEM_20220815T185931Z_20220817T153514Z_S2A_30_v0.1_VEG-ANOM-MAX.tif

+```

+

+Este nombre incluye una marca de tiempo (`20220815T185931Z`) y [una ubicación geográfica MGRS](https://en.wikipedia.org/wiki/Military_Grid_Reference_System) (`10TEM`). Este tipo de convenciones para la denominación de los archivos permite determinar los atributos de los datos ráster sin necesidad de recuperar todo el conjunto de datos, lo que puede reducir significativamente los costos de transferencia de los datos.

+

+---

+

+## Uso de GeoTIFF

+

+Hay numerosos formatos de archivo estándar que se utilizan para compartir muchos tipos de datos científicos (por ejemplo, [_HDF_](https://en.wikipedia.org/wiki/Hierarchical_Data_Format), [_Parquet_](https://parquet.apache.org/), [_CSV_](https://es.wikipedia.org/wiki/Valores_separados_por_comas), etc.). Además, hay [docenas de formatos de archivo especializados](https://www.spatialpost.com/list-common-gis-file-format/) para los [\*(_Sistemas de Información Geográfica (GIS)_](https://en.wikipedia.org/wiki/Geographic_information_system), por ejemplo, DRG, [_NetCDF_](https://docs.unidata.ucar.edu/nug/current/), USGS DEM, DXF, DWG, SVG, etc. En este tutorial, nos enfocaremos exclusivamente en el uso del formato de archivo _GeoTIFF_ para representar los datos ráster.

+

+[GeoTIFF](https://es.wikipedia.org/wiki/GeoTIFF) es un estándar de metadatos de dominio público diseñado para trabajar con archivos [Formato de archivo de imagen etiquetado](https://en.wikipedia.org/wiki/TIFF) ( (TIFF, por sus siglas en inglés de _Tagged Image File Format_))). El formato GeoTIFF permite incluir información de georreferenciación como metadatos geoespaciales dentro de los archivos de imagen. Las aplicaciones SIG utilizan GeoTIFF para fotografías aéreas, imágenes de satélite y mapas digitalizados. El formato de los datos GeoTIFF se describe detalladamente en el documento [estándar OGC GeoTIFF](https://www.ogc.org/standard/geotiff/).

+

+Un archivo GeoTIFF usualmente incluye metadatos geográficos como etiquetas embebidas. Estos pueden incluir metadatos de imágenes ráster tales como:

+

+- extensión espacial, es decir, el área que cubre el conjunto de datos,

+- el SRC qué se utiliza para almacenar los datos,

+- la resolución espacial, es decir, las dimensiones horizontal y vertical de los píxeles,

+- el número de valores del píxel en cada dirección,

+- el número de capas del archivo `.tif`,

+- elipsoides y geoides (es decir, modelos estimados de la forma de la Tierra), y

+- reglas matemáticas de proyección cartográfica para transformar los datos de un espacio tridimensional en una visualización bidimensional.

+

+A modo de ejemplo, carguemos los datos de un archivo GeoTIFF local utilizando el paquete `rioxarray` de Python.

+

+```{code-cell} python

+from pathlib import Path

+import rioxarray as rio

+

+LOCAL_PATH = Path.cwd().parent / 'assets' / 'OPERA_L3_DIST-ALERT-HLS_T10TEM_20220815T185931Z_20220817T153514Z_S2A_30_v0.1_VEG-ANOM-MAX.tif'

+```

+

+```{code-cell} python

+%%time

+da = rio.open_rasterio(LOCAL_PATH)

+```

+

+La función `rioxarray.open_rasterio` cargó los datos raster del archivo GeoTIFF local en un Xarray `DataArray` llamado `da`. Podemos analizar cómodamente el contenido de `da` en un cuaderno computacional Jupyter.

+

+```{code-cell} python

+da # examine contents

+```

+

+Este ráster es de alta resolución ($3600\times3600$ píxeles). Vamos a tomar una parte más pequeña (por ejemplo, un muestreo cada 200 píxeles) creando una instancia del objeto `slice` de Python `subset` y usando el método Xarray `DataArray.isel` para construir una matriz de menor resolución (que se renderizará más rápido). Entonces podemos hacer una visualización (renderizado por Matplotlib de manera predeterminada).

+

+```{code-cell} python

+subset = slice(0,None,200)

+view = da.isel(x=subset, y=subset)

+view.plot();

+```

+

+Observe que la visualización se etiqueta utilizando las coordenadas continuas (este, norte) asociadas a la extensión espacial de este ráster. Es decir, la sutil contabilidad necesaria para hacer un seguimiento de las coordenadas continuas y de píxel fue administrada de forma transparente por la API de la estructura de datos. ¡Eso es bueno!

+

+---

diff --git a/book/es-419/01_Geospatial_Background/03_Working_with_Vector_Data.md b/book/es-419/01_Geospatial_Background/03_Working_with_Vector_Data.md

new file mode 100644

index 0000000..bb7522d

--- /dev/null

+++ b/book/es-419/01_Geospatial_Background/03_Working_with_Vector_Data.md

@@ -0,0 +1,167 @@

+---

+jupyter:

+ jupytext:

+ text_representation:

+ extension: .md

+ format_name: markdown

+ format_version: "1.3"

+ jupytext_version: 1.16.2

+ kernelspec:

+ display_name: Python 3 (ipykernel)

+ language: python

+ name: python3

+---

+

+# Cómo trabajar con datos vectoriales

+

+Ciertas propiedades físicas de interés para los Sistemas de Informacion Geográfica (SIG) (en inglés, _Geographical Information System, GIS_), no se capturan convenientemente mediante datos ráster en cuadrículas discretas. Por ejemplo, las características geométricas de un paisaje, como carreteras, ríos y límites entre regiones, se describen mejor utilizando líneas o curvas en un sistema de coordenadas proyectado de manera adecuada. En el contexto de los GIS, los _datos vectoriales_ son representaciones geométricas de estos aspectos del paisaje.

+

+---

+

+## Cómo comprender de los Datos Vectoriales

+

+Los _datos vectoriales_ consisten en secuencias ordenadas de _vértices_, es decir, pares de números de la forma $(x,y)$. Las coordenadas continuas de cada vértice se asocian a una ubicación espacial física en algún Sistema de Referencia de Coordenadas (SRC) (en inglés, _Coordinate Reference System, CRS_) proyectado.

+

+- _Puntos_: Los vértices aislados representan funciones discretas de dimensión cero (por ejemplo, árboles, faroles, etc.).

+- _Líneas_ o _polilíneas_: Cualquier secuencia ordenada de por lo menos dos vértices constituye una _polilínea_ que puede visualizarse trazando líneas rectas entre vértices adyacentes. Las líneas o polilíneas son adecuadas para representar características unidimensionales como carreteras, caminos y ríos.

+- _Polígonos_: Cualquier secuencia ordenada de por lo menos tres vértices en la que el primero y el último coinciden constituye un _polígono_ (es decir, una forma cerrada). Los polígonos son adecuados para representar regiones bidimensionales como un lago o el límite de un bosque. Un uso común de los polígonos es representar las fronteras entre circunscripciones políticas (por ejemplo, países).

+

+Un conjunto único de datos vectoriales georreferenciados con un CRS en particular, generalmente contiene cualquier número de puntos, líneas o polígonos.

+

+

+

+Esta imagen muestra los tres tipos de datos vectoriales: puntos, líneas y polígonos. Fuente: *National Ecological Observatory Network* (NEON) (en español, Red Nacional de Observatorios Ecológicos).

+

+

+

+

+(Imágen de la izquierda) Vista aérea de un paisaje, (imágen de la derecha) representaciones vectoriales de puntos de características destacadas.

Fuente: *Sistemas de Información Geográfica* por Victor Olaya.

+

+

+

+

+(Imágen de la izquierda) Vista aérea de un río, (imágen de la derecha) representación vectorial de líneas del río.

Fuente: *Sistemas de Información Geográfica* por Victor Olaya.

+

+

+

+

+(Imagen de la izquierda) Vista aérea de un lago, (imagen de la derecha) representación vectorial poligonal del lago.

Fuente: *Sistemas de Información Geográfica* por Victor Olaya.

+

+

+Como ocurre con los datos ráster, generalmente las representaciones de datos vectoriales van acompañadas de metadatos para almacenar diversos atributos asociados al conjunto de datos. Los datos vectoriales usualmente se especifican con un nivel de precisión superior a la resolución que permiten la mayoría de las cuadrículas ráster. Además, las características geográficas representadas como datos vectoriales permiten efectuar cálculos que los datos ráster no permiten. Por ejemplo, es posible determinar diversas relaciones geométricas o topológicas:

+

+- ¿Un punto se encuentra dentro de los límites de una región geográfica?

+- ¿Dos carreteras se intersecan?

+- ¿Cuál es el punto más cercano de una carretera a otra región?

+

+Otras magnitudes geométricas, como la longitud de un río o la superficie de un lago, se obtienen aplicando técnicas de geometría computacional a representaciones de datos vectoriales.

+

+---

+

+## Uso de GeoJSON

+

+[GeoJSON](https://geojson.org/) es un subconjunto de [notación de objeto de JavaScript, (JSON, por las siglas en inglés de _JavaScript object notation_)](https://www.json.org). Fue desarrollado a principios de la década del 2000 para representar características geográficas simples junto con atributos no espaciales. El objetivo principal es ofrecer una especificación para la codificación de datos geoespaciales que sean decodificables por cualquier decodificador JSON.

+

+Los desarrolladores SIG responsables por GeoJSON lo diseñaron con la intención de que cualquier desarrollador web pudiera escribir un _parser_ GeoJSON personalizado, lo que permitiría muchas formas posibles de utilizar los datos geoespaciales más allá del software GIS estándar. Los detalles técnicos del formato GeoJSON se describen en el documento de estándares [RFC7946](https://datatracker.ietf.org/doc/html/rfc7946).

+

+Veamos cómo analizar y graficar archivos GeoJSON utilizando la librería [GeoPandas](https://geopandas.org/en/stable/). El archivo local `cables.geojson` almacena datos vectoriales de líneas que representan cables submarinos conectando diferentes masas de tierra.

+

+```{code-cell} python

+import geopandas as gpd

+from pathlib import Path

+

+FILE_STEM = Path.cwd().parent if 'book' == Path.cwd().parent.stem else 'book'

+GEOJSON = Path(FILE_STEM, 'assets/cables.geojson')

+print(GEOJSON)

+```

+

+```{code-cell} python

+with open(GEOJSON) as f:

+ text = f.read()

+print(text[:1500])

+```

+

+Intentar leer la salida GeoJSON anterior es complicado pero predecible. Los archivos JSON están pensados para ser consumidos por máquinas y, por tanto, no son muy legibles. Los archivos JSON están pensados genéricamente para ser consumidos por máquinas y, por lo tanto, no son muy legibles.

+

+Utilicemos la función `geopandas.read_file` para cargar los datos vectoriales en un `GeoDataFrame`.

+

+```{code-cell} python

+gdf = gpd.read_file(GEOJSON)

+display(gdf.head())

+gdf.info()

+```

+

+Hay 530 filas, cada una de las cuales corresponde a datos de línea (una secuencia conectada de segmentos de línea). Podemos utilizar el atributo `color` de la columna `GeoDataFrame` como una opción dentro de la llamada a `.plot` para graficar estos cables.

+

+```{code-cell} python

+gdf.geometry.plot(color=gdf.color, alpha=0.25);

+```

+

+Usemos un archivo remoto para crear otro `GeoDataFrame`, esta vez que contenga datos de polígonos.

+

+```{code-cell} python

+URL = "http://d2ad6b4ur7yvpq.cloudfront.net/naturalearth-3.3.0/ne_110m_land.geojson"

+gdf = gpd.read_file(URL)

+

+gdf

+```

+

+Esta vez, el gráfico mostrará polígonos rellenos correspondientes a los países del mundo.

+

+```{code-cell} python

+gdf.plot(color='green', alpha=0.25) ;

+```

+

+El método `GeoDataFrame.loc` nos permite graficar subconjuntos concretos de países.

+

+```{code-cell} python

+gdf.loc[15:90].plot(color='green', alpha=0.25) ;

+```

+

+---

+

+## Uso de archivos Shapefiles

+

+El estándar [_shapefile_](https://es.wikipedia.org/wiki/Shapefile) es un formato digital para distribuir datos vectoriales geoespaciales y sus atributos asociados. El estándar, desarrollado por [ESRI](https://es.wikipedia.org/wiki/Esri) hace unos 30 años, es compatible con la mayoría de las herramientas de _software_ SIG modernas. El nombre "_shapefile_" es un poco engañoso porque este tipo de archivo normalmente consiste en un conjunto de varios archivos (algunos obligatorios, otros opcionales) almacenados en un directorio común con un nombre de archivo común.

+

+De [Wikipedia](https://es.wikipedia.org/wiki/Shapefile):

+

+> El formato shapefile almacena la geometría como formas geométricas primitivas como puntos, líneas y polígonos. Estas formas, junto con los atributos de datos vinculados a cada una de ellas, crean la representación de los datos geográficos. El término "shapefile" es bastante común, pero el formato consiste en una colección de archivos con un prefijo de nombre de archivo común, almacenada en el mismo directorio. Los tres archivos obligatorios tienen las extensiones de archivo .shp, .shx y .dbf. El _shapefile_ real se refiere específicamente al archivo .shp, pero por sí solo está incompleto para su distribución, ya que se requieren los demás archivos de apoyo. El _software_ SIG heredado espera que el prefijo del nombre de archivo se limite a ocho caracteres para ajustarse a la convención de nombres de archivo DOS 8.3, aunque las aplicaciones de _software_ modernas aceptan archivos con nombres más largos.

+

+Los _shapefiles_ utilizan el formato [_Binario Bien Conocido_ (WKB, por las siglas en inglés de, _Well-known Binary_)(https://libgeos.org/specifications/wkb/) para codificar las geometrías. Se trata de un formato tabular compacto, es decir, los números de la fila y la columna asumen un valor significativo. Algunas limitaciones menores de este formato incluyen la restricción de los nombres en los campos de los atributos a 10 caracteres o menos y la escasa compatibilidad con Unicode. Como resultado, el texto suele abreviarse y codificarse en ASCII.

+

+Puedes consultar el [Informe técnico sobre _Shapefile_ de ESRI](https://www.esri.com/content/dam/esrisites/sitecore-archive/Files/Pdfs/library/whitepapers/pdfs/shapefile.pdf) para obtener más información sobre los _shapefiles_.

+

+#### Archivos obligatorios

+

+- Archivo principal (`.shp`): formato shape, por ejemplo, los datos vectoriales espaciales (puntos, líneas y polígonos) que representan la geometría del objeto.

+- Archivo de índice (`.shx`): posiciones de índice de formas (para permitir la recuperación de la geometría de los atributos).

+- Archivo dBASE (`.dbf`): archivo de base de datos estándar que almacena el formato de atributos (atributos en columnas para cada tipo en formato dBase IV, normalmente legible por, por ejemplo, Microsoft Access o Excel).

+

+Los registros corresponden en secuencia en cada uno de estos archivos, es decir, los atributos del registro $k$ del archivo `dbf` describen la característica del registro $k$ del archivo `shp` asociado.

+

+#### Archivos opcionales

+

+- Archivo de proyección (`.prj`): descripción del sistema de referencia de coordenadas correspondiente utilizando una [Representación en texto bien conocido de los sistemas de referencia de coordenadas _Well-known text representation of coordinate reference systems_ (WKT o WKT-CRS) (en español, representación en texto conocido de los sistemas de referencia de coordenadas )](https://en.wikipedia.org/wiki/Well-known_text_representation_of_coordinate_reference_systems).

+- Archivo _Extensible Markup Language_ (en español, lenguaje de marcado extensible) (`.xml`): [metadatos geoespaciales](https://en.wikipedia.org/wiki/Geospatial_metadata) en formato [XML](https://es.wikipedia.org/wiki/Extensible_Markup_Language).

+- Archivo de página de códigos (`.cpg`): archivos de texto sin formato para describir la codificación aplicada para crear el _shapefile_. Si tu _shapefile_ no tiene un archivo `.cpg`, entonces utiliza la codificación predeterminada del sistema.

+- Archivos de índice espacial (`.sbn` y `.sbx`): archivos de índice codificados para acelerar los tiempos de carga.

+

+Hay muchos archivos opcionales más. Consulta el [libro blanco](https://www.esri.com/content/dam/esrisites/sitecore-archive/Files/Pdfs/library/whitepapers/pdfs/shapefile.pdf) (en inglés, _whitepaper_).

+

+Al igual que los archivos GeoJSON, _los shapefiles_ se pueden leer directamente utilizando `geopandas.read_file` para cargar el archivo `.shp`. Lo haremos ahora utilizando un _shapefile_ de ejemplo que muestra la delimitación del área de un incendio forestal.

+

+```{code-cell} python

+SHAPEFILE = Path(FILE_STEM, 'assets/shapefiles/mckinney/McKinney_NIFC.shp')

+gdf = gpd.read_file(SHAPEFILE)

+gdf.info()

+gdf.head()

+```

+

+```{code-cell} python

+gdf.plot(color='red', alpha=0.5);

+```

+

+Volveremos a utilizar este _shapefile_ en cuadernos computacioales posteriores y explicaremos con más detalle lo que representa.

+

+---

diff --git a/book/es-419/02_Software_Tools_Techniques/01_Loading_Raster_Data_from_GeoTIFF_Files.md b/book/es-419/02_Software_Tools_Techniques/01_Loading_Raster_Data_from_GeoTIFF_Files.md

new file mode 100644

index 0000000..31ecea2

--- /dev/null

+++ b/book/es-419/02_Software_Tools_Techniques/01_Loading_Raster_Data_from_GeoTIFF_Files.md

@@ -0,0 +1,343 @@

+---

+jupyter:

+ jupytext:

+ text_representation:

+ extension: .md

+ format_name: markdown

+ format_version: "1.3"

+ jupytext_version: 1.16.2

+ kernelspec:

+ display_name: Python 3 (ipykernel)

+ language: python

+ name: python3

+---

+

+# Carga de datos ráster desde archivos GeoTIFF

+

+

+

+Dado que la mayoría de los datos geoespaciales con los que trabajaremos en este tutorial están almacenados en archivos GeoTIFF, debemos saber cómo trabajar con esos archivos. La solución más sencilla es utilizar [rioxarray](https://corteva.github.io/rioxarray/html/index.html). Esta solución se encarga de muchos detalles complicados de forma transparente. También podemos utilizar [Rasterio](https://rasterio.readthedocs.io/en/stable) como herramienta para leer datos o metadatos de archivos GeoTIFF. Un uso adecuado de Rasterio puede marcar una gran diferencia a la hora de trabajar con archivos remotos en la nube.

+

+

+

+```{code-cell} python jupyter={"source_hidden": false}

+import numpy as np

+import rasterio

+import rioxarray as rio

+from pathlib import Path

+

+FILE_STEM = Path.cwd().parent if 'book' == Path.cwd().parent.stem else 'book'

+```

+

+***

+

+## [rioxarray](https://corteva.github.io/rioxarray/html/index.html)

+

+

+

+`rioxarray` es un paquete que _extiende_ el paquete Xarray (hablaremos al respecto más adelante). Las principales funciones de `rioxarray` que utilizaremos en este tutorial son:

+

+- `rioxarray.open_rasterio` para cargar archivos GeoTIFF directamente en estructuras Xarray `DataArray`, y

+- `xarray.DataArray.rio` para proporcionar usos útiles (por ejemplo, para especificar información CRS).

+

+Para acostumbrarnos a trabajar con archivos GeoTIFF, utilizaremos algunos ejemplos específicos en este cuaderno computacional y en otros posteriores. Más adelante explicaremos qué tipo de datos contiene el archivo, por el momento, solo queremos acostumbrarnos a cargar datos.

+

+

+

+### Carga de archivos en un DataArray

+

+

+

+Observa en primer lugar que `open_rasterio` funciona con direcciones de archivos locales y URL remotas.

+

+- Como era de esperarse, el acceso local es más rápido que el remoto.

+

+

+

+```{code-cell} python jupyter={"source_hidden": false}

+%%time

+LOCAL_PATH = Path(FILE_STEM, 'assets/OPERA_L3_DIST-ALERT-HLS_T10TEM_20220815T185931Z_20220817T153514Z_S2A_30_v0.1_VEG-ANOM-MAX.tif')

+data = rio.open_rasterio(LOCAL_PATH)

+```

+

+```{code-cell} python jupyter={"source_hidden": false}

+%%time

+REMOTE_URL ='https://opera-provisional-products.s3.us-west-2.amazonaws.com/DIST/DIST_HLS/WG/DIST-ALERT/McKinney_Wildfire/OPERA_L3_DIST-ALERT-HLS_T10TEM_20220815T185931Z_20220817T153514Z_S2A_30_v0.1/OPERA_L3_DIST-ALERT-HLS_T10TEM_20220815T185931Z_20220817T153514Z_S2A_30_v0.1_VEG-ANOM-MAX.tif'

+data_remote = rio.open_rasterio(REMOTE_URL)

+```

+

+

+

+La siguiente operación compara elementos de un Xarray `DataArray` elemento a elemento (el uso del método `.all` es similar a lo que haríamos para comparar arrays NumPy). Por lo general, esta no es una forma recomendable de comparar matrices, series, dataframes u otras estructuras de datos grandes que contengan datos de punto flotante. Sin embargo, en este caso concreto, como las dos estructuras de datos se leyeron del mismo archivo almacenado en dos ubicaciones diferentes, la comparación elemento a elemento tiene sentido. Confirma que los datos cargados en la memoria desde dos fuentes distintas son idénticos en cada bit.

+

+

+

+```{code-cell} python jupyter={"source_hidden": false}

+(data_remote == data).all() # Verify that the data is identical from both sources

+```

+

+***

+

+## [rasterio](https://rasterio.readthedocs.io/en/stable)

+

+

+

+Esta sección puede omitirse si `rioxarray` funciona adecuadamente para nuestros análisis, es decir, si la carga de datos en la memoria no es prohibitiva. Cuando _no_ sea el caso, `rasterio` proporciona estrategias alternativas para explorar los archivos GeoTIFF. Es decir, el paquete `rasterio` ofrece formas de bajo nivel para cargar datos que `rioxarray` cuando sea necesario.

+

+De la [documentación de Rasterio](https://rasterio.readthedocs.io/en/stable):

+

+> Antes de Rasterio había una opción en Python para acceder a los diferentes tipos de archivos de datos ráster utilizados en el campo de los SIG: los enlaces de Python distribuidos con la [Biblioteca de Abstracción de Datos Geoespaciales](http://gdal.org/) (GDAL, por sus siglas en inglés de _Geospatial Data Abstraction Library_). Estos enlaces extienden Python, pero proporcionan poca abstracción para la Interface de programación de aplicaciones C (API C, por sus siglas en inglés de _Application Programming Interface_) de GDAL. Esto significa que los programas Python que los utilizan tienden a leerse y ejecutarse como programas de C. Por ejemplo, los enlaces a Python de GDAL obligan a los usuarios a tener cuidado con los punteros de C incorrectos, que pueden bloquear los programas. Esto es malo: entre otras consideraciones hemos elegido Python en vez de C para evitar problemas con los punteros.

+>

+> ¿Cómo sería tener una abstracción de datos geoespaciales en la biblioteca estándar de Python? ¿Una que utilizara características y modismos modernos del lenguaje Python? ¿Una que liberara a los usuarios de la preocupación por los punteros incorrectos y otras trampas de la programación en C? El objetivo de Rasterio es ser este tipo de biblioteca de datos ráster, que exprese el modelo de datos de GDAL utilizando menos clases de extensión no idiomáticas y tipos y protocolos de Python más idiomáticos, a la vez que funciona tan rápido como los enlaces de Python de GDAL.

+>

+> Alto rendimiento, menor carga cognitiva, código más limpio y transparente. Eso es Rasterio.

+

+

+

+***

+

+### Abrir archivos con rasterio.open

+

+```{code-cell} python jupyter={"source_hidden": false}

+# Show rasterio.open works using context manager

+LOCAL_PATH = Path(FILE_STEM, 'assets/OPERA_L3_DIST-ALERT-HLS_T10TEM_20220815T185931Z_20220817T153514Z_S2A_30_v0.1_VEG-ANOM-MAX.tif')

+print(LOCAL_PATH)

+```

+

+

+

+Dada una fuente de datos (por ejemplo, un archivo GeoTIFF en el contexto actual), podemos abrir un objeto `DatasetReader` asociado utilizando `rasterio.open`. Técnicamente, debemos recordar cerrar el objeto después. Es decir, nuestro código quedaría así:

+

+```{code-cell} python

+ds = rasterio.open(LOCAL_PATH)

+# ..

+# do some computation

+# ...

+ds.close()

+```

+

+Al igual que con el manejo de archivos en Python, podemos utilizar un _administrador de contexto_ (es decir, una cláusula `with`) en su lugar.

+

+```python

+with rasterio.open(LOCAL_PATH) as ds:

+ # ...

+ # do some computation

+ # ...

+

+# more code outside the scope of the with block.

+```

+

+El conjunto de datos se cerrará automáticamente fuera del bloque `with`.

+

+

+

+```{code-cell} python jupyter={"source_hidden": false}

+with rasterio.open(LOCAL_PATH) as ds:

+ print(f'{type(ds)=}')

+ assert not ds.closed

+

+# outside the scope of the with block

+assert ds.closed

+```

+

+

+

+La principal ventaja al utilizar `rasterio.open` en vez de `rioxarray.open_rasterio` para abrir un archivo es que este último método abre el archivo y carga inmediatamente su contenido en un `DataDarray` en la memoria.

+

+Por el contrario, al utilizar `rasterio.open` se abre el archivo en su lugar y su contenido _no_ se carga inmediatamente en la memoria. Los datos del archivo _pueden_ leerse, pero esto debe hacerse explícitamente. Esto representa una gran diferencia cuando se trabaja con datos remotos. Transferir todo el contenido a través de una red de datos implica ciertos costos. Por ejemplo, si examinamos los metadatos, que suelen ser mucho más pequeños y pueden transferirse rápidamente, podemos descubrir, por ejemplo, que no está justificado mover todo un _array_ de datos a través de la red.

+

+

+

+***

+

+### Análisis de los atributos DatasetReader

+

+

+

+Cuando se abre un archivo utilizando `rasterio.open`, el objeto instanciado es de la clase `DatasetReader`. Esta clase tiene una serie de atributos y métodos de interés para nosotros:

+

+| | | |

+| --------- | ----------- | -------- |

+| `profile` | `height` | `width` |

+| `shape` | `count` | `nodata` |

+| `crs` | `transform` | `bounds` |

+| `xy` | `index` | `read` |

+

+En primer lugar, dado un `DatasetReader` `ds` asociado a una fuente de datos, el análisis de `ds.profile` devuelve cierta información de diagnóstico.

+

+

+

+```{code-cell} python jupyter={"source_hidden": false}

+with rasterio.open(LOCAL_PATH) as ds:

+ print(f'{ds.profile=}')

+```

+

+

+

+Los atributos `ds.height`, `ds.width`, `ds.shape`, `ds.count`, `ds.nodata` y `ds.transform` se incluyen en la salida de `ds.profile`, pero también son accesibles individualmente.

+

+

+

+```{code-cell} python jupyter={"source_hidden": false}

+with rasterio.open(LOCAL_PATH) as ds:

+ print(f'{ds.height=}')

+ print(f'{ds.width=}')

+ print(f'{ds.shape=}')

+ print(f'{ds.count=}')

+ print(f'{ds.nodata=}')

+ print(f'{ds.crs=}')

+ print(f'{ds.transform=}')

+```

+

+***

+

+### Lectura de datos en la memoria

+

+

+

+El método `ds.read` carga un _array_ del archivo de datos en la memoria. Ten en cuenta que esto se puede hacer en archivos locales o remotos.

+

+

+

+```{code-cell} python jupyter={"source_hidden": false}

+%%time

+with rasterio.open(LOCAL_PATH) as ds:

+ array = ds.read()

+ print(f'{array.shape=}')

+```

+

+```{code-cell} python jupyter={"source_hidden": false}

+%%time

+with rasterio.open(REMOTE_URL) as ds:

+ array = ds.read()

+ print(f'{array.shape=}')

+```

+

+```{code-cell} python jupyter={"source_hidden": false}

+print(f'{type(array)=}')

+```

+

+

+

+El _array_ cargado en la memoria con `ds.read` es una matriz NumPy. Este puede ser encapsulado por un Xarray `DataArray` si proporcionamos código adicional para especificar las etiquetas de las coordenadas y demás.

+

+

+

+***

+

+### Mapeo de coordenadas

+

+

+

+Anteriormente, cargamos los datos de un archivo local en un `DataArray` llamado `da` utilizando `rioxarray.open_rasterio`.

+

+

+

+```{code-cell} python jupyter={"source_hidden": false}

+da = rio.open_rasterio(LOCAL_PATH)

+da

+```

+

+

+

+De este modo se simplificó la carga de datos ráster de un archivo GeoTIFF en un Xarray `DataArray` a la vez que cargaban los metadatos automáticamente. En particular, las coordenadas asociadas a los píxeles se almacenaron en `da.coords` (los ejes de coordenadas predeterminados son `band`, `x` y `y` para este _array_ tridimensional).

+

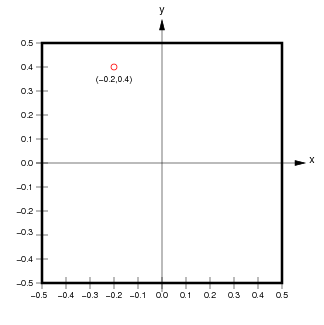

+Si ignoramos la dimensión extra de `band`, los píxeles de los datos ráster se asocian con coordenadas de píxel (enteros) y coordenadas espaciales (valores reales, típicamente un punto en el centro de cada píxel).

+

+

+

+(de `http://ioam.github.io/topographica`)

+

+Los accesores `da.isel` y `da.sel` nos permiten extraer porciones del _array_ utilizando coordenadas de píxel o coordenadas espaciales, respectivamente.

+

+

+

+

+

+Si utilizamos `rasterio.open` para abrir un archivo, el atributo `transform` de `DatasetReader` proporciona los detalles sobre cómo realizar la conversión entre coordenadas de píxel y espaciales. Utilizaremos esta propiedad en algunos de los casos prácticos más adelante.

+

+

+

+```{code-cell} python jupyter={"source_hidden": false}

+with rasterio.open(LOCAL_PATH) as ds:

+ print(f'{ds.transform=}')

+ print(f'{np.abs(ds.transform[0])=}')

+ print(f'{np.abs(ds.transform[4])=}')

+```

+

+

+

+El atributo `ds.transform` es un objeto que describe una [_transformación afín_](https://es.wikipedia.org/wiki/Transformaci%C3%B3n_af%C3%ADn) (representada anteriormente como una matriz $2\times3$). Observa que los valores absolutos de las entradas diagonales de la matriz `ds.transform` dan las dimensiones espaciales de los píxeles ($30\mathrm{m}\times30\mathrm{m}$ en este caso).

+

+También podemos utilizar este objeto para convertir las coordenadas de los píxeles en las coordenadas espaciales correspondientes.

+

+

+

+```{code-cell} python jupyter={"source_hidden": false}

+with rasterio.open(LOCAL_PATH) as ds:

+ print(f'{ds.transform * (0,0)=}') # top-left pixel

+ print(f'{ds.transform * (0,3660)=}') # bottom-left pixel

+ print(f'{ds.transform * (3660,0)=}') # top-right pixel

+ print(f'{ds.transform * (3660,3660)=}') # bottom-right pixel

+```

+

+

+

+El atributo `ds.bounds` muestra los límites de la región espacial (izquierda, abajo, derecha, arriba).

+

+

+

+```{code-cell} python jupyter={"source_hidden": false}

+with rasterio.open(LOCAL_PATH) as ds:

+ print(f'coordinate bounds: {ds.bounds=}')

+```

+

+

+

+El método `ds.xy` también convierte coordenadas de índice entero en coordenadas continuas. Observa que `ds.xy` asigna enteros al centro de los píxeles. Los bucles siguientes imprimen la primera esquina superior izquierda de las coordenadas en coordenadas de píxel y, después, las coordenadas espaciales correspondientes.

+

+

+

+```{code-cell} python jupyter={"source_hidden": false}

+with rasterio.open(LOCAL_PATH) as ds:

+ for k in range(3):

+ for l in range(4):

+ print(f'({k:2d},{l:2d})','\t', end='')

+ print()

+ print()

+ for k in range(3):

+ for l in range(4):

+ e,n = ds.xy(k,l)

+ print(f'({e},{n})','\t', end='')

+ print()

+ print()

+```

+

+

+

+`ds.index` hace lo contrario: dadas las coordenadas espaciales `(x,y)`, devuelve los índices enteros del píxel que contiene ese punto.

+

+

+

+```{code-cell} python jupyter={"source_hidden": false}

+with rasterio.open(LOCAL_PATH) as ds:

+ print(ds.index(500000, 4700015))

+```

+

+

+

+Estas conversiones pueden ser complicadas, sobre todo porque las coordenadas de píxel corresponden a los centros de los píxeles y también porque la segunda coordenada espacial `y` _disminuye_ a medida que la segunda coordenada de píxel _aumenta_. Hacer un seguimiento de detalles tediosos como este es en parte la razón por la que resulta útil cargar desde `rioxarray`, es decir, que nosotros lo hagamos. Pero vale la pena saber que podemos reconstruir este mapeo si es necesario a partir de los metadatos en el archivo GeoTIFF (utilizaremos este hecho más adelante).

+

+

+

+```{code-cell} python jupyter={"source_hidden": false}

+with rasterio.open(LOCAL_PATH) as ds:

+ print(ds.bounds)

+ print(ds.transform * (0.5,0.5)) # Maps to centre of top left pixel

+ print(ds.xy(0,0)) # Same as above

+ print(ds.transform * (0,0)) # Maps to top left corner of top left pixel

+ print(ds.xy(-0.5,-0.5)) # Same as above

+ print(ds.transform[0], ds.transform[4])

+```

+

+***

diff --git a/book/es-419/02_Software_Tools_Techniques/02_Array_Manipulation_with_Xarray.md b/book/es-419/02_Software_Tools_Techniques/02_Array_Manipulation_with_Xarray.md

new file mode 100644

index 0000000..d99c045

--- /dev/null

+++ b/book/es-419/02_Software_Tools_Techniques/02_Array_Manipulation_with_Xarray.md

@@ -0,0 +1,317 @@

+---

+jupyter:

+ jupytext:

+ text_representation:

+ extension: .md

+ format_name: markdown

+ format_version: "1.3"

+ jupytext_version: 1.16.2

+ kernelspec:

+ display_name: Python 3 (ipykernel)

+ language: python

+ name: python3

+---

+

+# Manipulación de arreglos con [Xarray](https://docs.xarray.dev/en/stable/index.html)

+

+

+

+Hay numerosas formas de trabajar con datos geoespaciales, así que elegir una herramienta puede ser difícil. La principal librería que utilizaremos es [_Xarray_](https://docs.xarray.dev/en/stable/index.html) por sus estructuras de datos `DataArray` y `Dataset`, y sus utilidades asociadas, así como [NumPy](https://numpy.org) y [Pandas](https://pandas.pydata.org) para manipular arreglos numéricos homogéneos y datos tabulares, respectivamente.

+

+

+

+```{code-cell} python jupyter={"source_hidden": false}

+from warnings import filterwarnings

+filterwarnings('ignore')

+from pathlib import Path

+import numpy as np, pandas as pd, xarray as xr

+import rioxarray as rio

+

+FILE_STEM = Path.cwd().parent if 'book' == Path.cwd().parent.stem else 'book'

+```

+

+***

+

+

+

+ +

+La principal estructura de datos de Xarray es [`DataArray`](https://docs.xarray.dev/en/stable/user-guide/data-structures.html), que ofrece soporte para arreglos multidimensionales etiquetados. El [Projecto Pythia](https://foundations.projectpythia.org/core/xarray.html) proporciona una amplia introducción a este paquete. Nos enfocaremos principalmente en las partes específicas del API Xarray que utilizaremos para nuestros análisis geoespaciales particulares.

+

+Vamos a cargar una estructura de datos `xarray.DataArray` de ejemplo desde un archivo cuya ubicación viene determinada por `LOCAL_PATH`.

+

+

+

+```{code-cell} python jupyter={"source_hidden": false}

+LOCAL_PATH = Path(FILE_STEM, 'assets/OPERA_L3_DIST-ALERT-HLS_T10TEM_20220815T185931Z_20220817T153514Z_S2A_30_v0.1_VEG-ANOM-MAX.tif')

+data = rio.open_rasterio(LOCAL_PATH)

+```

+

+***

+

+## Análisis de la `repr` enriquecida de `DataArray`

+

+

+

+Cuando se utiliza un cuaderno computacional de Jupyter, los datos Xarray `DataArray` `data` se pueden analizar de forma interactiva.

+

+- La celda de salida contiene un cuaderno computacional Jupyter `repr` enriquecido para la clase `DataArray`.

+- Los triángulos situados junto a los encabezados "Coordinates", "Indexes" y "Attributes" pueden pulsarse con el mouse para mostrar una vista ampliada.

+

+

+

+```{code-cell} python jupyter={"source_hidden": false}

+print(f'{type(data)=}\n')

+data

+```

+

+***

+

+## Análisis de los atributos de `DataArray` mediante programación

+

+

+

+Por supuesto, aunque esta vista gráfica es práctica, también es posible acceder a varios atributos de `DataArray` mediante programación. Esto nos permite escribir una lógica programatica para manipular los `DataArray` condicionalmente según sea necesario. Por ejemplo:

+

+

+

+```{code-cell} python jupyter={"source_hidden": false}

+print(data.coords)

+```

+

+

+

+Las dimensiones `data.dims` son las cadenas/etiquetas asociadas a los ejes del `DataArray`.

+

+

+

+```{code-cell} python jupyter={"source_hidden": false}

+data.dims

+```

+

+

+

+Podemos extraer las coordenadas como arreglos NumPy unidimensionales (homogéneas) utilizando los atributos `coords` y `.values`.

+

+

+

+```{code-cell} python jupyter={"source_hidden": false}

+print(data.coords['x'].values)

+```

+

+

+

+`data.attrs` es un diccionario que contiene otros metadatos analizados a partir de las etiquetas GeoTIFF (los "Atributos" en la vista gráfica). Una vez más, esta es la razón por la que `rioxarray` es útil. Es posible escribir código que cargue datos de varios formatos de archivo en Xarray `DataArray`, pero este paquete encapsula mucho del código desordenado que, por ejemplo, rellenaría `data.attrs`.

+

+

+

+```{code-cell} python jupyter={"source_hidden": false}

+data.attrs

+```

+

+***

+

+## Uso del método de acceso `rio` de `DataArray`

+

+

+

+Tal como se mencionó, `rioxarray` extiende la clase `xarray.DataArray` con un método de acceso llamado `rio`. El método de acceso `rio` agrega efectivamente un espacio de nombres con una variedad de atributos. Podemos usar una lista de comprensión de Python para mostrar los que no empiezan con guión bajo (los llamados métodos/atributos "private" y "dunder").

+

+

+

+```{code-cell} python jupyter={"source_hidden": false}

+[name for name in dir(data.rio) if not name.startswith('_')]

+```

+

+

+

+El atributo `data.rio.crs` es importante para nuestros propósitos. Proporciona acceso al sistema de referencia de coordenadas asociado a este conjunto de datos ráster.

+

+

+

+```{code-cell} python jupyter={"source_hidden": false}

+print(type(data.rio.crs))

+print(data.rio.crs)

+```

+

+

+

+El atributo `.rio.crs` es una estructura de datos de la clase `CRS` del proyecto [pyproj](https://pyproj4.github.io/pyproj/stable/index.html). La `repr` de Python para esta clase devuelve una cadena como `EPSG:32610`. Este número se refiere al [conjunto de datos de parámetros geodésicos _European Petroleum Survey Group_ (EPGS)](https://en.wikipedia.org/wiki/EPSG_Geodetic_Parameter_Dataset) (en español, Grupo Europeo de Estudio sobre el Petróleo).

+

+De [Wikipedia](https://en.wikipedia.org/wiki/EPSG_Geodetic_Parameter_Dataset):

+

+> El [EPSG Geodetic Parameter Dataset (también conocido como registro EPSG)](https://en.wikipedia.org/wiki/EPSG_Geodetic_Parameter_Dataset) es un registro público de [datums geodésicos](https://es.wikipedia.org/wiki/Sistema_de_referencia_geod%C3%A9sico), [sistemas de referencia espacial](https://es.wikipedia.org/wiki/Sistema_de_referencia_espacial), [elipsoides terrestres](https://es.wikipedia.org/wiki/Elipsoide_de_referencia), transformaciones de coordenadas y [unidades de medida](https://es.wikipedia.org/wiki/Unidad_de_medida) relacionadas, originados por un miembro del [EPGS](https://en.wikipedia.org/wiki/European_Petroleum_Survey_Group) en 1985. A cada entidad se le asigna un código EPSG comprendido entre 1024 y 32767, junto con una representación estándar de [texto conocido (WKT)](https://en.wikipedia.org/wiki/Well-known_text_representation_of_coordinate_reference_systems) legible por máquina. El mantenimiento del conjunto de datos corre a cargo del Comité de Geomática [IOGP](https://en.wikipedia.org/wiki/International_Association_of_Oil_%26_Gas_Producers).

+

+

+

+***

+

+## Manipulación de los datos en un `DataArray`

+

+

+

+Estos datos se almacenan utilizando un CRS [ sistema de coordenadas universal transversal de Mercator (UTM)](https://en.wikipedia.org/wiki/Universal_Transverse_Mercator_coordinate_system) (por sus siglas en inglés de _Mercator transversal universal_) particular. Las etiquetas de las coordenadas serían convencionalmente _este_ y _norte_. Sin embargo, a la hora de hacer el trazo, será conveniente utilizar _longitud_ y _latitud_ en su lugar. Reetiquetaremos las coordenadas para reflejar esto, es decir, la coordenada llamada `x` se reetiquetará como `longitude` y la coordenada llamada `y` se reetiquetará como `latitude`.

+

+

+

+```{code-cell} python jupyter={"source_hidden": false}

+data = data.rename({'x':'longitude', 'y':'latitude'})

+```

+

+```{code-cell} python jupyter={"source_hidden": false}

+print(data.coords)

+```

+

+

+

+Una vez más, aunque los valores numéricos almacenados en los arreglos de coordenadas no tienen sentido estrictamente como valores (longitud, latitud), aplicaremos estas etiquetas ahora para simplificar el trazado más adelante.

+

+Los objetos Xarray `DataArray` permiten estraer subconjuntos de forma muy similar a las listas de Python. Las dos celdas siguientes extraen ambas el mismo subarreglo mediante dos llamadas a métodos diferentes.

+

+

+

+```{code-cell} python jupyter={"source_hidden": false}

+data.isel(longitude=slice(0,2))

+```

+

+```{code-cell} python jupyter={"source_hidden": false}

+data.sel(longitude=[499_995, 500_025])

+```

+

+

+

+En vez de utilizar paréntesis para cortar secciones de arreglos (como en NumPy), para `DataArray`, podemos utilizar los métodos `sel` o `isel` para seleccionar subconjuntos por valores de coordenadas continuas o por posiciones enteras (es decir, coordenadas de "píxel") respectivamente. Esto es similar al uso de `.loc` and `.iloc` en Pandas para extraer entradas de una Pandas `Series` o `DataFrame`.

+

+Si tomamos un subconjunto en 2D de los `DataArray` `data` 3D, podemos graficarlo usando el método de acceso `.plot` (hablaremos al respecto más adelante).

+

+

+

+```python jupyter={"source_hidden": false}

+data.isel(band=0).plot();

+```

+

+

+

+Este gráfico tarda un poco en procesarse porque el arreglo representado tiene $3,600\times3,600$ píxeles. Podemos utilizar la función `slice` de Python para extraer, por ejemplo, cada 100 píxeles en cualquier dirección para trazar una imagen de menor resolución mucho más rápido.

+

+

+

+```{code-cell} python jupyter={"source_hidden": false}

+steps = 100

+subset = slice(0,None,steps)

+view = data.isel(longitude=subset, latitude=subset, band=0)

+view.plot();

+```

+

+

+

+El gráfico producido es bastante oscuro (lo que refleja que la mayoría de las entradas son cero según la leyenda). Observa que los ejes se etiquetan automáticamente utilizando las `coords` que renombramos antes.

+

+

+

+***

+

+## Extracción de datos `DataArray` a NumPy, Pandas

+

+

+

+Observa que un `DataArray` encapsula de un arreglo NumPy. Ese arreglo NumPy se puede recuperar usando el atributo `.values`.

+

+

+

+```{code-cell} python jupyter={"source_hidden": false}

+array = data.values

+print(f'{type(array)=}')

+print(f'{array.shape=}')

+print(f'{array.dtype=}')

+print(f'{array.nbytes=}')

+```

+

+

+

+Estos datos ráster se almacenan como datos enteros sin signo de 8 bits, es decir, un byte por cada píxel. Un entero de 8 bits sin signo puede representar valores enteros entre 0 y 255. En un arreglo con algo más de trece millones de elementos, eso significa que hay muchos valores repetidos. Podemos verlo poniendo los valores de los píxeles en una Pandas `Series` y usando el método `.value_counts`.

+

+

+

+```{code-cell} python jupyter={"source_hidden": false}

+s_flat = pd.Series(array.flatten()).value_counts()

+s_flat.sort_index()

+```

+

+

+

+La mayoría de las entradas de este arreglo ráster son cero. Los valores numéricos varían entre 0 y 100 con la excepción de unos 1,700 píxeles con el valor 255. Esto tendrá más sentido cuando hablemos de la especificación del producto de datos DIST.

+

+

+

+***

+

+## Acumulación y concatenación de una secuencia de `DataArrays`

+

+

+

+A menudo es conveniente apilar múltiples arreglos bidimensionales de datos ráster en un único arreglo tridimensional. En NumPy, esto se hace típicamente con la función [`numpy.concatenate`](https://numpy.org/doc/stable/reference/generated/numpy.concatenate.html). Hay una funcionalidad similar en Xarray—[`xarray.concat`](https://docs.xarray.dev/en/stable/generated/xarray.concat.html) (que es similar en diseño a la función [`pandas.concat`](https://pandas.pydata.org/pandas-docs/stable/reference/api/pandas.concat.html)). La principal diferencia entre `numpy.concatenate` y `xarray.concat` es que esta última función debe tener en cuenta las _coordenadas etiquetadas_, mientras que la primera no. Esto es importante cuando, por ejemplo, los ejes de coordenadas de dos rásters se superponen pero no están perfectamente alineados.

+

+Para ver cómo funciona el apilamiento de rásteres, empezaremos haciendo una lista de tres archivos GeoTIFF (almacenados localmente), inicializando una lista de `stack` vacía, y después construyendo una lista de `DataArrays` en un bucle.

+

+

+

+```{code-cell} python jupyter={"source_hidden": false}

+RASTER_FILES = list((Path(FILE_STEM, 'assets').glob('OPERA*VEG*.tif')))

+

+stack = []

+for path in RASTER_FILES:

+ print(f"Stacking {path.name}..")

+ data = rio.open_rasterio(path).rename(dict(x='longitude', y='latitude'))

+ band_name = path.stem.split('_')[-1]

+ data.coords.update({'band': [band_name]})

+ data.attrs = dict(description=f"OPERA DIST product", units=None)

+ stack.append(data)

+```

+

+

+

+He aquí algunas observaciones importantes sobre el bucle de código anterior:

+

+- El uso de `rioxarray.open_rasterio` para cargar un Xarray `DataArray` en memoria hace mucho trabajo por nosotros. En particular, se asegura de que las coordenadas continuas están alineadas con las coordenadas de píxeles subyacentes.

+- De manera predeterminada, `data.coords` tiene las claves `x` y `y` que elegimos reetiquetar como `longitude` y `latitude` respectivamente. Técnicamente, los valores de las coordenadas continuas que se cargaron desde este archivo GeoTIFF en particular se expresan en coordenadas UTM (es decir, este y norte), pero, posteriormente, al trazar, las etiquetas `longitude` y `latitude` serán más convenientes.

+- `data.coords['band']`, tal como se cargó desde el archivo, tiene el valor `1`. Elegimos sobrescribir ese valor con el nombre de la banda (que extraemos del nombre del archivo como `band_name`).

+- De manera predeterminada, `rioxarray.open_rasterio` completa `data.attrs` con pares clave-valor extraídos de las etiquetas TIFF. Para diferentes bandas/capas, estos diccionarios de atributos podrían tener claves o valores conflictivos. Puede ser aconsejable conservar estos metadatos en algunas circunstancias. Simplemente elegimos descartarlos en este contexto para evitar posibles conflictos. El diccionario mínimo de atributos de la estructura de datos final tendrá como únicas claves `description` y `units`.

+

+Dado que construimos una lista de `DataArray` en la lista `stack`, podemos ensamblar un `DataArray` tridimensional utilizando `xarray.concat`.

+

+

+

+```{code-cell} python jupyter={"source_hidden": false}

+stack = xr.concat(stack, dim='band')

+```

+

+

+

+La función `xarray.concat` acepta una secuencia de objetos `xarray.DataArray` con dimensiones conformes y los _concatena_ a lo largo de una dimensión especificada. Para este ejemplo, apilamos rásteres bidimensionales que corresponden a diferentes bandas o capas. Por eso utilizamos la opción `dim='band'` en la llamada a `xarray.concat`. Más adelante, en cambio, apilaremos rásteres bidimensionales a lo largo de un eje _temporal_ (esto implica un código ligeramente diferente para garantizar el etiquetado y la alineación correctos).

+

+Examinemos `stack` mediante su `repr`en este cuaderno computacional Jupyter.

+

+

+

+```{code-cell} python jupyter={"source_hidden": false}

+stack

+```

+

+

+

+Observa que `stack` tiene un CRS asociado que fue analizado por `rioxarray.open_rasterio`.

+

+

+

+```{code-cell} python jupyter={"source_hidden": false}

+stack.rio.crs

+```

+

+

+

+Este proceso es muy útil para el análisis (suponiendo que haya suficiente memoria disponible para almacenar toda la colección de rásteres). Más adelante, utilizaremos este enfoque varias veces para manipular colecciones de rásteres de dimensiones conformes. El apilamiento se puede utilizar para producir una visualización dinámica con un control deslizante o, alternativamente, para producir un gráfico estático.

+

+

+

+***

diff --git a/book/es-419/02_Software_Tools_Techniques/03_Data_Visualization_with_GeoViews_HvPlot.md b/book/es-419/02_Software_Tools_Techniques/03_Data_Visualization_with_GeoViews_HvPlot.md

new file mode 100644

index 0000000..e156d8b

--- /dev/null

+++ b/book/es-419/02_Software_Tools_Techniques/03_Data_Visualization_with_GeoViews_HvPlot.md

@@ -0,0 +1,486 @@

+---

+jupyter:

+ jupytext:

+ text_representation:

+ extension: .md

+ format_name: markdown

+ format_version: "1.3"

+ jupytext_version: 1.16.2

+ kernelspec:

+ display_name: Python 3 (ipykernel)

+ language: python

+ name: python3

+---

+

+# Visualización de datos con GeoViews y HvPlot

+

+

+

+Las principales herramientas que utilizaremos para la visualización de datos provienen de la familia [Holoviz](https://holoviz.org/) de librerías Python, principalmente [GeoViews](https://geoviews.org/) y [hvPlot](https://hvplot.holoviz.org/). Estas están construidas en gran parte sobre [HoloViews](https://holoviews.org/) y soportan múltiples _backends_ para la representación de gráficos ([Bokeh](http://bokeh.pydata.org/) para visualización interactiva y [Matplotlib](http://matplotlib.org/) para gráficos estáticos con calidad de publicación.

+

+

+

+***

+

+## [GeoViews](https://geoviews.org/)

+

+

+

+

+

+La principal estructura de datos de Xarray es [`DataArray`](https://docs.xarray.dev/en/stable/user-guide/data-structures.html), que ofrece soporte para arreglos multidimensionales etiquetados. El [Projecto Pythia](https://foundations.projectpythia.org/core/xarray.html) proporciona una amplia introducción a este paquete. Nos enfocaremos principalmente en las partes específicas del API Xarray que utilizaremos para nuestros análisis geoespaciales particulares.

+

+Vamos a cargar una estructura de datos `xarray.DataArray` de ejemplo desde un archivo cuya ubicación viene determinada por `LOCAL_PATH`.

+

+

+

+```{code-cell} python jupyter={"source_hidden": false}

+LOCAL_PATH = Path(FILE_STEM, 'assets/OPERA_L3_DIST-ALERT-HLS_T10TEM_20220815T185931Z_20220817T153514Z_S2A_30_v0.1_VEG-ANOM-MAX.tif')

+data = rio.open_rasterio(LOCAL_PATH)

+```

+

+***

+

+## Análisis de la `repr` enriquecida de `DataArray`

+

+

+

+Cuando se utiliza un cuaderno computacional de Jupyter, los datos Xarray `DataArray` `data` se pueden analizar de forma interactiva.

+

+- La celda de salida contiene un cuaderno computacional Jupyter `repr` enriquecido para la clase `DataArray`.

+- Los triángulos situados junto a los encabezados "Coordinates", "Indexes" y "Attributes" pueden pulsarse con el mouse para mostrar una vista ampliada.

+

+

+

+```{code-cell} python jupyter={"source_hidden": false}

+print(f'{type(data)=}\n')

+data

+```

+

+***

+

+## Análisis de los atributos de `DataArray` mediante programación

+

+

+

+Por supuesto, aunque esta vista gráfica es práctica, también es posible acceder a varios atributos de `DataArray` mediante programación. Esto nos permite escribir una lógica programatica para manipular los `DataArray` condicionalmente según sea necesario. Por ejemplo:

+

+

+

+```{code-cell} python jupyter={"source_hidden": false}

+print(data.coords)

+```

+

+

+

+Las dimensiones `data.dims` son las cadenas/etiquetas asociadas a los ejes del `DataArray`.

+

+

+

+```{code-cell} python jupyter={"source_hidden": false}

+data.dims

+```

+

+

+

+Podemos extraer las coordenadas como arreglos NumPy unidimensionales (homogéneas) utilizando los atributos `coords` y `.values`.

+

+

+

+```{code-cell} python jupyter={"source_hidden": false}

+print(data.coords['x'].values)

+```

+

+

+

+`data.attrs` es un diccionario que contiene otros metadatos analizados a partir de las etiquetas GeoTIFF (los "Atributos" en la vista gráfica). Una vez más, esta es la razón por la que `rioxarray` es útil. Es posible escribir código que cargue datos de varios formatos de archivo en Xarray `DataArray`, pero este paquete encapsula mucho del código desordenado que, por ejemplo, rellenaría `data.attrs`.

+

+

+

+```{code-cell} python jupyter={"source_hidden": false}

+data.attrs

+```

+

+***

+

+## Uso del método de acceso `rio` de `DataArray`

+

+

+

+Tal como se mencionó, `rioxarray` extiende la clase `xarray.DataArray` con un método de acceso llamado `rio`. El método de acceso `rio` agrega efectivamente un espacio de nombres con una variedad de atributos. Podemos usar una lista de comprensión de Python para mostrar los que no empiezan con guión bajo (los llamados métodos/atributos "private" y "dunder").

+

+

+

+```{code-cell} python jupyter={"source_hidden": false}

+[name for name in dir(data.rio) if not name.startswith('_')]

+```

+

+

+

+El atributo `data.rio.crs` es importante para nuestros propósitos. Proporciona acceso al sistema de referencia de coordenadas asociado a este conjunto de datos ráster.

+

+

+

+```{code-cell} python jupyter={"source_hidden": false}

+print(type(data.rio.crs))

+print(data.rio.crs)

+```

+

+

+

+El atributo `.rio.crs` es una estructura de datos de la clase `CRS` del proyecto [pyproj](https://pyproj4.github.io/pyproj/stable/index.html). La `repr` de Python para esta clase devuelve una cadena como `EPSG:32610`. Este número se refiere al [conjunto de datos de parámetros geodésicos _European Petroleum Survey Group_ (EPGS)](https://en.wikipedia.org/wiki/EPSG_Geodetic_Parameter_Dataset) (en español, Grupo Europeo de Estudio sobre el Petróleo).

+

+De [Wikipedia](https://en.wikipedia.org/wiki/EPSG_Geodetic_Parameter_Dataset):

+

+> El [EPSG Geodetic Parameter Dataset (también conocido como registro EPSG)](https://en.wikipedia.org/wiki/EPSG_Geodetic_Parameter_Dataset) es un registro público de [datums geodésicos](https://es.wikipedia.org/wiki/Sistema_de_referencia_geod%C3%A9sico), [sistemas de referencia espacial](https://es.wikipedia.org/wiki/Sistema_de_referencia_espacial), [elipsoides terrestres](https://es.wikipedia.org/wiki/Elipsoide_de_referencia), transformaciones de coordenadas y [unidades de medida](https://es.wikipedia.org/wiki/Unidad_de_medida) relacionadas, originados por un miembro del [EPGS](https://en.wikipedia.org/wiki/European_Petroleum_Survey_Group) en 1985. A cada entidad se le asigna un código EPSG comprendido entre 1024 y 32767, junto con una representación estándar de [texto conocido (WKT)](https://en.wikipedia.org/wiki/Well-known_text_representation_of_coordinate_reference_systems) legible por máquina. El mantenimiento del conjunto de datos corre a cargo del Comité de Geomática [IOGP](https://en.wikipedia.org/wiki/International_Association_of_Oil_%26_Gas_Producers).

+

+

+

+***

+

+## Manipulación de los datos en un `DataArray`

+

+

+

+Estos datos se almacenan utilizando un CRS [ sistema de coordenadas universal transversal de Mercator (UTM)](https://en.wikipedia.org/wiki/Universal_Transverse_Mercator_coordinate_system) (por sus siglas en inglés de _Mercator transversal universal_) particular. Las etiquetas de las coordenadas serían convencionalmente _este_ y _norte_. Sin embargo, a la hora de hacer el trazo, será conveniente utilizar _longitud_ y _latitud_ en su lugar. Reetiquetaremos las coordenadas para reflejar esto, es decir, la coordenada llamada `x` se reetiquetará como `longitude` y la coordenada llamada `y` se reetiquetará como `latitude`.

+

+

+

+```{code-cell} python jupyter={"source_hidden": false}

+data = data.rename({'x':'longitude', 'y':'latitude'})

+```

+

+```{code-cell} python jupyter={"source_hidden": false}

+print(data.coords)

+```

+

+

+

+Una vez más, aunque los valores numéricos almacenados en los arreglos de coordenadas no tienen sentido estrictamente como valores (longitud, latitud), aplicaremos estas etiquetas ahora para simplificar el trazado más adelante.

+

+Los objetos Xarray `DataArray` permiten estraer subconjuntos de forma muy similar a las listas de Python. Las dos celdas siguientes extraen ambas el mismo subarreglo mediante dos llamadas a métodos diferentes.

+

+

+

+```{code-cell} python jupyter={"source_hidden": false}

+data.isel(longitude=slice(0,2))

+```

+

+```{code-cell} python jupyter={"source_hidden": false}

+data.sel(longitude=[499_995, 500_025])

+```

+

+

+

+En vez de utilizar paréntesis para cortar secciones de arreglos (como en NumPy), para `DataArray`, podemos utilizar los métodos `sel` o `isel` para seleccionar subconjuntos por valores de coordenadas continuas o por posiciones enteras (es decir, coordenadas de "píxel") respectivamente. Esto es similar al uso de `.loc` and `.iloc` en Pandas para extraer entradas de una Pandas `Series` o `DataFrame`.

+

+Si tomamos un subconjunto en 2D de los `DataArray` `data` 3D, podemos graficarlo usando el método de acceso `.plot` (hablaremos al respecto más adelante).

+

+

+

+```python jupyter={"source_hidden": false}

+data.isel(band=0).plot();

+```

+

+

+

+Este gráfico tarda un poco en procesarse porque el arreglo representado tiene $3,600\times3,600$ píxeles. Podemos utilizar la función `slice` de Python para extraer, por ejemplo, cada 100 píxeles en cualquier dirección para trazar una imagen de menor resolución mucho más rápido.

+

+

+

+```{code-cell} python jupyter={"source_hidden": false}

+steps = 100

+subset = slice(0,None,steps)

+view = data.isel(longitude=subset, latitude=subset, band=0)

+view.plot();

+```

+

+

+

+El gráfico producido es bastante oscuro (lo que refleja que la mayoría de las entradas son cero según la leyenda). Observa que los ejes se etiquetan automáticamente utilizando las `coords` que renombramos antes.

+

+

+

+***

+

+## Extracción de datos `DataArray` a NumPy, Pandas

+

+

+

+Observa que un `DataArray` encapsula de un arreglo NumPy. Ese arreglo NumPy se puede recuperar usando el atributo `.values`.

+

+

+

+```{code-cell} python jupyter={"source_hidden": false}

+array = data.values

+print(f'{type(array)=}')

+print(f'{array.shape=}')

+print(f'{array.dtype=}')

+print(f'{array.nbytes=}')

+```

+

+

+

+Estos datos ráster se almacenan como datos enteros sin signo de 8 bits, es decir, un byte por cada píxel. Un entero de 8 bits sin signo puede representar valores enteros entre 0 y 255. En un arreglo con algo más de trece millones de elementos, eso significa que hay muchos valores repetidos. Podemos verlo poniendo los valores de los píxeles en una Pandas `Series` y usando el método `.value_counts`.

+

+

+

+```{code-cell} python jupyter={"source_hidden": false}

+s_flat = pd.Series(array.flatten()).value_counts()

+s_flat.sort_index()

+```

+

+

+

+La mayoría de las entradas de este arreglo ráster son cero. Los valores numéricos varían entre 0 y 100 con la excepción de unos 1,700 píxeles con el valor 255. Esto tendrá más sentido cuando hablemos de la especificación del producto de datos DIST.

+

+

+

+***

+

+## Acumulación y concatenación de una secuencia de `DataArrays`

+

+

+

+A menudo es conveniente apilar múltiples arreglos bidimensionales de datos ráster en un único arreglo tridimensional. En NumPy, esto se hace típicamente con la función [`numpy.concatenate`](https://numpy.org/doc/stable/reference/generated/numpy.concatenate.html). Hay una funcionalidad similar en Xarray—[`xarray.concat`](https://docs.xarray.dev/en/stable/generated/xarray.concat.html) (que es similar en diseño a la función [`pandas.concat`](https://pandas.pydata.org/pandas-docs/stable/reference/api/pandas.concat.html)). La principal diferencia entre `numpy.concatenate` y `xarray.concat` es que esta última función debe tener en cuenta las _coordenadas etiquetadas_, mientras que la primera no. Esto es importante cuando, por ejemplo, los ejes de coordenadas de dos rásters se superponen pero no están perfectamente alineados.

+

+Para ver cómo funciona el apilamiento de rásteres, empezaremos haciendo una lista de tres archivos GeoTIFF (almacenados localmente), inicializando una lista de `stack` vacía, y después construyendo una lista de `DataArrays` en un bucle.

+

+

+

+```{code-cell} python jupyter={"source_hidden": false}

+RASTER_FILES = list((Path(FILE_STEM, 'assets').glob('OPERA*VEG*.tif')))

+

+stack = []

+for path in RASTER_FILES:

+ print(f"Stacking {path.name}..")

+ data = rio.open_rasterio(path).rename(dict(x='longitude', y='latitude'))

+ band_name = path.stem.split('_')[-1]

+ data.coords.update({'band': [band_name]})

+ data.attrs = dict(description=f"OPERA DIST product", units=None)

+ stack.append(data)

+```

+

+

+

+He aquí algunas observaciones importantes sobre el bucle de código anterior:

+

+- El uso de `rioxarray.open_rasterio` para cargar un Xarray `DataArray` en memoria hace mucho trabajo por nosotros. En particular, se asegura de que las coordenadas continuas están alineadas con las coordenadas de píxeles subyacentes.

+- De manera predeterminada, `data.coords` tiene las claves `x` y `y` que elegimos reetiquetar como `longitude` y `latitude` respectivamente. Técnicamente, los valores de las coordenadas continuas que se cargaron desde este archivo GeoTIFF en particular se expresan en coordenadas UTM (es decir, este y norte), pero, posteriormente, al trazar, las etiquetas `longitude` y `latitude` serán más convenientes.

+- `data.coords['band']`, tal como se cargó desde el archivo, tiene el valor `1`. Elegimos sobrescribir ese valor con el nombre de la banda (que extraemos del nombre del archivo como `band_name`).

+- De manera predeterminada, `rioxarray.open_rasterio` completa `data.attrs` con pares clave-valor extraídos de las etiquetas TIFF. Para diferentes bandas/capas, estos diccionarios de atributos podrían tener claves o valores conflictivos. Puede ser aconsejable conservar estos metadatos en algunas circunstancias. Simplemente elegimos descartarlos en este contexto para evitar posibles conflictos. El diccionario mínimo de atributos de la estructura de datos final tendrá como únicas claves `description` y `units`.

+

+Dado que construimos una lista de `DataArray` en la lista `stack`, podemos ensamblar un `DataArray` tridimensional utilizando `xarray.concat`.

+